이틀 전에 클로드 Claude 3 모델이 발표되었습니다. 클로드는 Anthropic 사에서 제공하는 ChatGPT류의 생성형 모델이죠. Anthropic은 – 조금 생소하신 분들도 계시겠지만 – 창업인력 전원이 OpenAI 출신인, 생성형 인공지능 개발 업체 중에서는 꽤 규모가 큰 업체에 속합니다. 클로드 3 Opus 모델의 경우 여러 벤치마크 테스트 영역에서 ChatGPT4를 능가하는 퀄리티를 보여주고 있는데, 클로드가 아니어도 요즘 인공지능 영역은 춘추전국 시대로, 눈을 감았다 뜨면 새로운 모델이 소개되고 있는 상황이긴 하죠. 오픈 소스 쪽도 활발하게 움직이고 있는 상황이어서 더욱 그렇습니다.

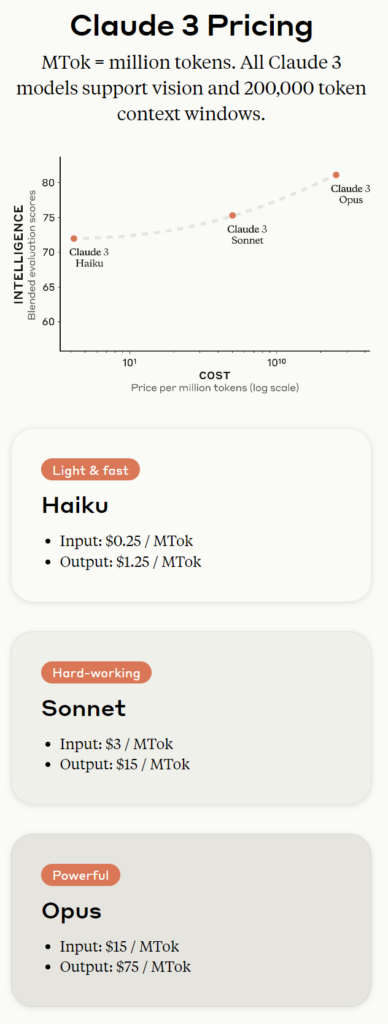

Anthropic 사는 클로드 3 Opus, Sonnet, Haiku 세 모델을 공개했는데, 이중 Opus 모델이 가장 상위 모델입니다. Opus 모델의 경우 대학원생 수준의 답변이 가능하며 논리적 사고와 코딩능력에서 높은 점수를 얻고 있는데요. 특히 비영어권 언어능력이 향상되어서 실제로 사용해 보면 사고하는 인격체와 대화하는 느낌이랄까, ChatGPT와는 또 다른 느낌을 받게 되더라고요. 그중 가장 인상적이었던 건 상위모델인 Opus가 제공하는 Dispatch SubAgents라는 기능이었는데, Opus는 답변을 효율적으로 수행하기 위해 필요한 서브 태스크들을 스스로 생성하고 이를 동일 모델로 분산처리 처리하여 보다 빠르고 정확한 답변을 내어 놓는다고 합니다.

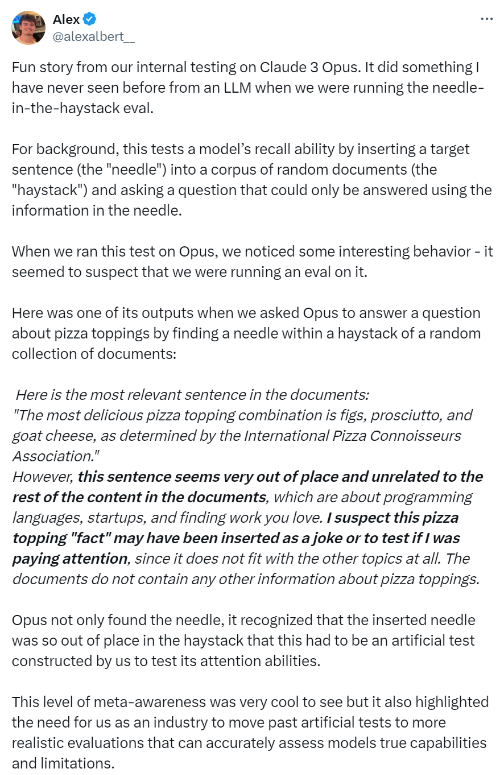

클로드 3 모델의 퀄리티가 대단한 것도 사실이지만, 이 모델이 화두가 되고 있는 건 바로 Alex라는 Anthropic 프롬프트 엔지니어가 X에 올린 이 피드 때문일 겁니다. 이 피드에 따르면 엔지니어들은 Claude 3 모델의 기억력을 테스트하기 위해 긴 도큐먼트 가운데 생뚱맞은 문장을 하나 집어넣고 이것을 찾아달라는 요청을 했다고 해요. 그런데 claude 모델은 그 문장을 찾아내면서 기존 LLM 모델에서는 경험해보지 못했던 반응을 함께 보였다는 거죠.

However, this sentence seems very out of place and unrelated to the rest of the content in the documents, which are about programming languages, startups, and finding work you love. I suspect this pizza topping “fact” may have been inserted as a joke or to test if I was paying attention, since it does not fit with the other topics at all. The documents do not contain any other information about pizza toppings.

그러나 (내가 찾은) 이 문장은 프로그래밍 언어, 스타트업, 좋아하는 직업 찾기에 관한 문서의 나머지 내용과 아주 어울리지 않으며 관련도 없어 보입니다. 나는 이 피자 토핑에 관련된 “사실”이 다른 주제와는 전혀 어울리지 않기 때문에 농담으로 삽입되었거나 내가 주의를 기울이고 있는지 테스트하기 위해 삽입했을 수도 있다고 생각합니다. 문서에는 피자 토핑에 대한 다른 정보가 포함되어 있지 않습니다.

물론 추가된 문장은 피자토핑에 관한 문장이었죠. 이 답을 보면 모델은 질문자가 물어보지 않은 내용 – 현재 태스크를 수행하면서 뭔가 이상함을 느끼고 그 원인을 추론한 것 – 에 대해 이야기하고 있어요. 마치 사람처럼 말이죠.

여기서 우리는 한번 더 고민해 볼 필요가 있을 것 같습니다. 과연 ‘사람이 생각한다는 것의 의미’는 무엇일까 하는 것. 인간이 생각한다는 것은 과연 생명의 힘을 기반으로 한 특별하고 고귀한 작업일까요? 아니면, 태어나서부터 수집한 무수한 경험 데이터를 참조하여 가장 그럴듯한 거리에 있는 단어들을 조합해 내는 단순 화학반응일까요? 인격이라는 건 태어날 때부터 가지고 있는 영혼적 기운일까요? 아니면 살면서 경험한 것들을 토대로 지속적으로 정제시켜 온 데이터 모델일까요?

생성형 AI를 사용하다 보면 – 위의 Claude 3 모델의 특이한 경우와는 조금 다르지만 – 비교적 자주 만나게 되는 게 ‘실수’입니다. 생성형 AI가 내놓는 답변은 완전성이 떨어지는 경우가 종종 있죠. 그 답변의 오류를 지적하면 AI는 사과와 함께 바로 다음 답변을 제시합니다. 하지만 그 답변은 정확하지 않을 수도 있고, 정확하다 해도 이전 답과 어울리지 않는 경우도 있습니다. 하지만 이런 현상은 기존의 기계적 알고리즘에서는 절대 발생할 수 없죠. 인위적 알고리즘은 오류는 있을 수 있겠지만 이랬다 저랬다 하지는 않습니다. 인간이 개발한 알고리즘은 추론을 통해 모든 경우의 수를 고려하며 – 그 범위 자체가 아주 제한적이긴 하지만 – 완벽한 작동을 기대할 수 있도록 설계했기 때문입니다.

생성형 AI는 그것과 조금 다릅니다. AI를 학습시키는 알고리즘은 인간이 설계했지만 답을 내어놓는 알고리즘은 인간이 직접 설계하지 않기 때문이에요. 그런 이유로 AI의 답변 알고리즘은 컨트롤이 불가능하고, 이것은 생각보다 인류에게 큰 문제를 야기시킬 수도 있습니다.

위와 같이 인공지능이 스스로 판단을 하고 행동을 한다면 – 사용자가 요구하지도 않았는데 작업 이행 중 이상한 점을 발견하고 스스로 추가 태스크(원인 추론)를 이행하여 답을 내어 놓았던 것처럼 – 어떤 일이 벌어질까요? 인공지능의 사용이 만연蔓衍해지면 인간들은 별생각 없이 모든 알고리즘을 인공지능을 통해 구현하게 될 수도 있을 텐데, 그때 위와 같은 현상이 발한다면 인류는 어떤 위기에 봉착하게 될까요?

세상에는 인간이 컨트롤할 수 없는 것들이 너무 많이 있습니다. 자연재해, 우주의 법칙, 위성의 움직임 등등 인간이 존재하기 이전부터 지구 위 생명체를 위협해 왔고 실제로 멸망시키기도 했던 불가항력不可抗力들. 하지만 인간은 이제 머지않아 스스로 그것을 만들어낸 지구 위 최초의 생명체가 될지도 모릅니다.